1. 자연어의 특성

- 자연어를 기계가 처리하도록 하기 위해서 먼저 자연어를 기계가 이해할 수 있는 언어로 바꾸는 방법을 알아야 함

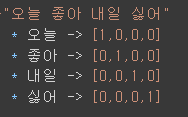

- 토큰화 작업의 결과인 단어 사전을 기계가 이해할 수 있는 언어로 표현하는 과정이고,

단어 사전 내 단어 하나를 어떻게 표현할까의 문제로 볼 수 있음

1. 단어의 유사성과 모호성 |

|

2. 언어의 모호성을 해소 |

|

2. 임베딩 구축 방법

1. 임베딩이란? |

|

2. 임베딩의 역할 |

|

3. 단어 출현 빈도의 기반한 임베딩 추축 방법

|

|

4. 단어의 순서 |

|

3. 텍스트 유사도

- 두 개의 자연어 텍스트가 얼마나 유사한지를 나타내는 방법

- 유사도를 정의하거나 판단하는 척도가 주관적이기 떄문에, 최대한 정량화하는 방법을 찾는 것이 중요함

1. 유클리디안 거리 기반 유사도 |

|

2. 맨해튼 거리 기반 유사도 |

|

3. 코사인 유사도 |

|

4. 자카드 유사도 |

|

'AI > 자연어처리' 카테고리의 다른 글

| 06. 자연어처리 - 워드 임베딩 (6) | 2024.06.25 |

|---|---|

| 05. 자연어처리 - 임베딩 실습 (0) | 2024.06.25 |

| 03. 자연어처리 - 전처리 실습 (0) | 2024.06.24 |

| 02. 자연어처리 - 진행순서 (0) | 2024.06.24 |

| 01. 자연어처리 - 개요 (6) | 2024.06.24 |