1. ELmo(Embeddings from Language Model)

- 2018년 논문에서 제안된 새로운 워드 임베딩 방법론

- ELMo의 가장 큰 특징은 가전 훈련된 언어 모델(Pre-Trained Language Model)을 사용한다는 것

- 논문: https://arxiv.org/abs/1802.05365

- 참고사이트: https://wikidocs.net/33930

09-09 엘모(Embeddings from Language Model, ELMo)

논문 링크 : https://aclweb.org/antholog…

wikidocs.net

1. ELmo 특징 |

|

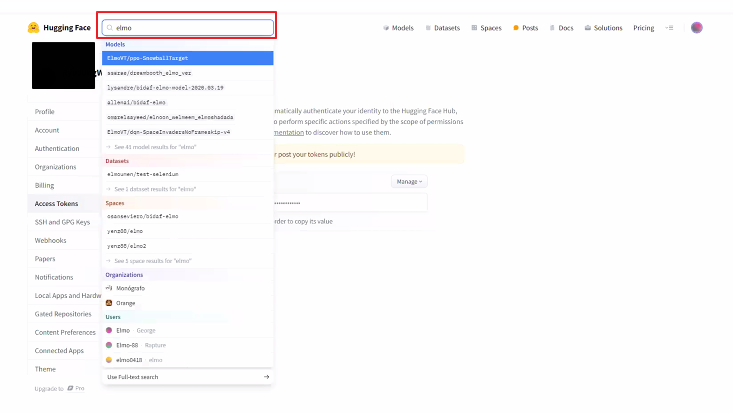

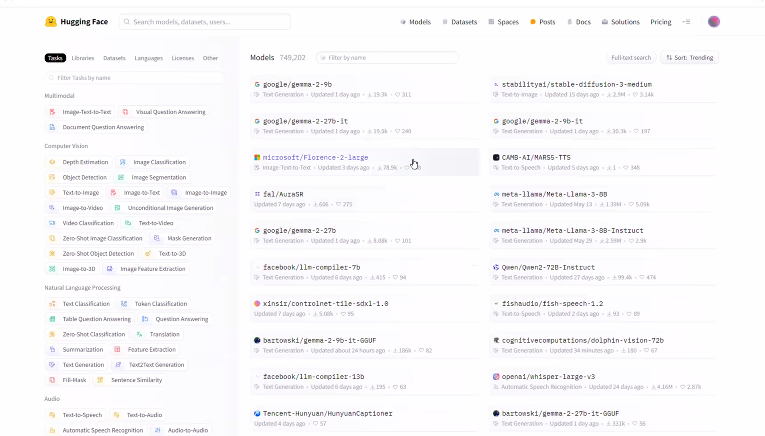

2. 허깅페이스(Hugging Face) |

|

- 허깅페이스 토큰 발행 방법

◼ import

|

import json

import requests

|

◼ 토큰 넣기

|

API_TOKEN = '본인 토큰 넣기'

headers = {"Authorization" : f"Bearer {API_TOKEN}"}

|

◼ API에 POST 요청보내기

|

def query(data):

data = json.dumps(data)

response = requests.request("POST", API_URL, headers=headers, data=data)

return json.loads(response.content.decode("utf-8"))

|

◼(1)

|

data = query(

{

"inputs": {

"question":"너의 이름이 뭐니?",

"context" : "나는 서울에 살고 있고 내 이름은 김사과야"

}

}

)

|

|

print(data)

|

| {'score': 0.001044555683620274, 'start': 19, 'end': 23, 'answer': '김사과야'} |

◼ (2)

|

data = query(

{

"inputs": {

"question":"What's my name?",

"context" : "My name is Kim and I live in Seoul"

}

}

)

|

|

print(data)

|

| {'score': 0.8682517409324646, 'start': 11, 'end': 14, 'answer': 'Kim'} |

2. 트랜스포머(Transformer)

- 2017년 구글이 발표한 논문 "Attention is all you need"에서 발표된 모델

- Seq2Seq의 구조인 인코더-디코더를 따르면서도 어텐션(Attention)만으로 구현된 모델

- RNN을 사용하지 않고 인토더-디토더 구조를 설계하였음에도 번역 성능에서 RNN보다 우수한 성능을 보여줬으며 2017년 이후 지금까지 다양한 분야에서 사용되는 범용적인 모델

- 논문: https://arxiv.org/abs/1706.03762

- 참고사이트: https://wikidocs.net/31379

16-01 트랜스포머(Transformer)

* 이번 챕터는 앞서 설명한 어텐션 메커니즘 챕터에 대한 사전 이해가 필요합니다. 트랜스포머(Transformer)는 2017년 구글이 발표한 논문인 Attention i…

wikidocs.net

1. 트렌스포머의 특징 |

|

2. 포지션널 인코딩(Positional Encoding) |

|

3. 트랜스포머 셀프 어텍션 |

|

4. 멀티헤드 어텐션 |

|

5. Position-wise FFNN(Feed Forward Neural Network) |

|

6. 잔차 연결과 레이어 정규화 |

|

7. 디코더(Decoder) |

|

8. 트랜스포머 파라미터 |

|

3. [NLP] 자연어 작업 종류

'AI > 자연어처리' 카테고리의 다른 글

| 16. 문장 임베딩 | GPT (0) | 2024.07.05 |

|---|---|

| 15. 문장임베딩 | BERT (1) | 2024.07.05 |

| 13. 문장 임베딩 | Attention Meshanism (0) | 2024.07.04 |

| 12. 문장 임베딩 | Seq2Seq (1) | 2024.07.03 |

| 11. LSTM과 GRU (0) | 2024.07.02 |